BahasBerita.com – Meta baru saja meluncurkan generasi terbaru dari model kecerdasan buatan (AI) mereka, Llama 4. Peluncuran ini menandai babak baru dalam perkembangan teknologi AI open source dengan kemampuan yang mengesankan. Pada April 2025, Meta memperkenalkan tiga model dalam keluarga Llama 4: Llama 4 Scout, Llama 4 Maverick, dan Llama 4 Behemoth (yang masih dalam tahap pengembangan). Model-model ini menawarkan terobosan signifikan dalam hal arsitektur, kemampuan multimodal, dan konteks window yang sangat besar hingga 10 juta token. Artikel ini akan membahas secara mendalam tentang Llama 4, fitur-fiturnya, kemampuannya, dan potensi aplikasinya yang dapat mengubah cara kita berinteraksi dengan teknologi AI.

Apa itu Llama 4?

Llama 4 adalah generasi terbaru dari Large Language Model (LLM) yang dikembangkan oleh Meta. Berbeda dengan model AI sebelumnya, Llama 4 menerapkan pendekatan multimodal native yang mampu memproses dan mengintegrasikan berbagai jenis data termasuk teks, gambar, dan video. Model ini juga menggunakan arsitektur Mixture of Experts (MoE) yang inovatif, memungkinkan performa tinggi dengan penggunaan sumber daya komputasi yang lebih efisien.

Sebelum Llama 4, Meta telah meluncurkan beberapa versi model Llama, dengan Llama 3 dan Llama 3.1 menjadi pendahulu langsung. Perkembangan model-model ini mencerminkan komitmen Meta untuk menciptakan teknologi AI yang kuat namun tetap dapat diakses secara luas melalui pendekatan open source.

Model-model dalam Keluarga Llama 4

Llama 4 Scout

Llama 4 Scout adalah model multimodal tujuan umum dengan 17 miliar parameter aktif yang didistribusikan di antara 16 expert, mencapai total 109 miliar parameter. Salah satu fitur paling revolusioner dari Scout adalah kemampuannya mendukung konteks window hingga 10 juta token, meningkat drastis dari 128 ribu token pada Llama 3.

Spesifikasi ini membuka berbagai kemungkinan aplikasi baru, termasuk:

-

Peringkasan multi-dokumen

-

Analisis aktivitas pengguna yang ekstensif untuk tugas personal

-

Penalaran terhadap basis kode yang sangat besar

Model ini telah dioptimasi dan diquantisasi ke Int4 agar dapat berjalan pada satu GPU NVIDIA H100, menjadikannya relatif lebih dapat diakses dibandingkan model-model besar lainnya.

Llama 4 Maverick

Llama 4 Maverick adalah model yang lebih besar dan lebih kuat dengan 17 miliar parameter aktif, tetapi menggunakan 128 expert yang mencapai total 400 miliar parameter. Model ini mendukung konteks window hingga 1 juta token dan menawarkan pemahaman teks dan gambar performa tinggi.

Maverick diklaim sebagai model multimodal terbaik di kelasnya, melampaui model-model sebanding seperti GPT-4o dan Gemini 2.0 dalam benchmark koding, penalaran, multilingualisme, konteks panjang, dan gambar. Bahkan kompetitif dengan model yang jauh lebih besar seperti DeepSeek v3.1 dalam hal koding dan penalaran.

Berdasarkan data dari hasil pengujian, Llama 4 Maverick sangat cepat dengan MLX pada M3 Ultra, dengan model 4-bit menghasilkan 1100 token pada kecepatan 50 token per detik.

Llama 4 Behemoth

Llama 4 Behemoth adalah model terbesar dalam keluarga Llama 4 yang masih dalam tahap pengembangan dan belum dirilis. Meta menyebutnya sebagai “salah satu LLM terpintar di dunia” yang berfungsi sebagai “guru” untuk model-model lain.

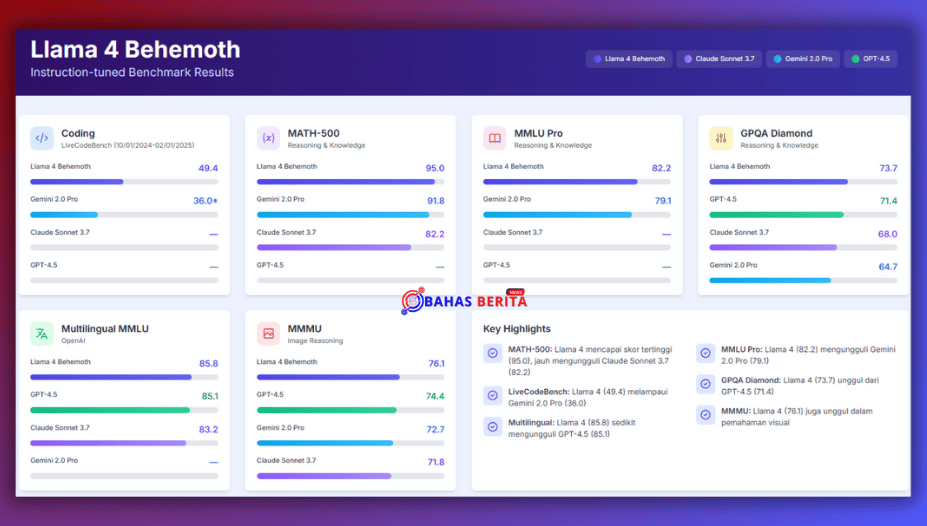

Berdasarkan informasi yang tersedia, Behemoth memiliki sekitar 2 triliun parameter dengan 288 miliar parameter aktif. Meta mengklaim bahwa model ini mampu mengalahkan GPT-4.5, Claude Sonnet 3.7, dan Gemini 2.0 Pro pada benchmark yang berfokus pada STEM seperti MATH-500 dan GPQA Diamond.

Inovasi Arsitektur Mixture of Experts (MoE) pada Llama 4

Salah satu inovasi terpenting dalam Llama 4 adalah penggunaan arsitektur Mixture of Experts (MoE). Berbeda dengan model AI monolitik tradisional, model MoE terdiri dari jaringan neural khusus (“expert”) dengan komponen “router” yang mengarahkan token masuk ke expert yang sesuai.

Cara kerja arsitektur ini sangat menarik: ketika Anda meminta Llama 4 untuk menulis kode, model akan mengaktifkan expert koding sambil membiarkan expert lain dalam keadaan dorman. Ini berarti Anda mendapatkan performa khusus tanpa beban komputasi penuh dari model dengan parameter besar.

Dalam konteks praktis, arsitektur MoE memberikan beberapa keuntungan:

-

Respons lebih cepat namun tetap sangat cerdas

-

Penggunaan sumber daya komputasi yang lebih efisien

-

Kemampuan untuk menangani lebih banyak kueri secara bersamaan

-

Deployment yang lebih mudah tanpa memerlukan GPU besar tunggal

Arsitektur MoE memungkinkan Llama 4 memperluas kapasitasnya tanpa meningkatkan biaya secara signifikan, memberikan keuntungan besar untuk implementasi perusahaan.

Kemampuan Multimodal pada Llama 4

Llama 4 dirancang dengan multimodalitas native, mengintegrasikan pendekatan early-fusion untuk menyatukan token teks dan visi ke dalam backbone model yang terpadu. Early-fusion merupakan langkah maju yang signifikan, karena memungkinkan pre-training model secara bersama dengan jumlah besar data teks, gambar, dan video tidak berlabel.

Berbeda dengan Llama 3.2 yang menggunakan parameter terpisah untuk teks dan visi, Llama 4 menggunakan arsitektur early-fusion di mana semua parameter secara native memahami teks dan gambar. Ini merupakan peningkatan arsitektur yang signifikan—pendekatan multimodal sebelumnya memerlukan penggabungan model terpisah. Dengan Llama 4, semuanya terintegrasi, membuat aplikasi multimodal lebih sederhana untuk dibangun dan lebih koheren dalam eksekusi.

Meta juga meningkatkan encoder visi di Llama 4, yang didasarkan pada MetaCLIP tetapi dilatih terpisah bersamaan dengan model Llama yang dibekukan untuk lebih baik mengadaptasi encoder ke LLM.

Konteks Window yang Revolusioner

Llama 4 Scout mendukung konteks window hingga 10 juta token—salah satu model open source pertama dengan kemampuan ini. Ini merupakan peningkatan drastis dari 128 ribu token pada Llama 3 dan membuka berbagai kemungkinan baru dalam pengolahan informasi.

Konteks window yang besar ini memungkinkan:

-

Pemrosesan basis kode lengkap untuk analisis

-

Peringkasan beberapa dokumen sekaligus

-

Pemeliharaan percakapan yang lebih panjang dan koheren dengan konteks

-

Pembangunan sistem RAG (Retrieval Augmented Generation) yang lebih canggih.

Llama 4 Scout dilatih dengan konteks window 256 ribu, yang memberdayakan model dasar dengan kemampuan generalisasi panjang lanjutan. Meta menunjukkan hasil menjanjikan dalam tugas-tugas seperti retrieval dengan “retrieval needle in haystack” untuk teks serta cumulative negative log-likelihoods (NLLs) lebih dari 10 juta token kode.

Performa dan Benchmark Llama 4

Meta mengklaim bahwa model-model Llama 4 menunjukkan performa luar biasa dalam berbagai benchmark. Llama 4 Maverick diklaim melampaui model-model sebanding seperti GPT-4o dan Gemini 2.0 dalam benchmark koding, penalaran, multilingualisme, konteks panjang, dan gambar.

Sementara itu, Llama 4 Behemoth, yang masih dalam pengembangan, dilaporkan mampu mengalahkan GPT-4.5, Claude Sonnet 3.7, dan Gemini 2.0 Pro pada benchmark yang berfokus pada STEM seperti MATH-500 dan GPQA Diamond.

Dari segi kecepatan, Llama 4 menunjukkan performa yang mengesankan. Dengan akselerasi oleh software open-source NVIDIA, model Llama 4 dapat mencapai lebih dari 40 ribu token output per detik pada GPU NVIDIA Blackwell B200.

Aplikasi Praktis Llama 4

Kemampuan Llama 4 membuka berbagai aplikasi praktis di berbagai sektor:

Untuk Bisnis dan Perusahaan

-

Analisis dokumen multimodal (teks + grafik + cuplikan video)

-

Asisten AI yang dapat memproses laporan lengkap dan memberikan ringkasan terintegrasi

-

Pengembangan aplikasi kustom dengan kemampuan pemahaman gambar dan teks.

Untuk Pengembang

-

Pemrosesan basis kode yang sangat besar untuk analisis dan optimasi

-

Pembangunan aplikasi RAG yang lebih canggih dengan konteks window besar

-

Penciptaan asisten AI yang lebih personal dan kontekstual

Untuk Industri Spesifik

-

Kesehatan: Analisis rekam medis panjang termasuk gambar diagnostik

-

Pendidikan: Pemrosesan materi pembelajaran multimodal dan penjelasan yang didukung gambar

-

Media dan Hiburan: Analisis konten multimodal dan generasi konten

Cara Menjalankan Llama 4 di Perangkat Lokal

Menjalankan Llama 4 di perangkat lokal membutuhkan spesifikasi hardware yang cukup tinggi, terutama untuk model penuh. Namun, dengan quantisasi yang tepat, model ini dapat dijalankan pada hardware yang lebih terjangkau.

Persyaratan Hardware

-

Untuk Llama 4 Scout (dengan quantisasi Int4): Minimal GPU NVIDIA H100 atau yang setara

-

RAM: Disarankan 128GB atau lebih untuk konteks window besar

-

VRAM: Minimal 36GB disarankan untuk performa optimal

Langkah-langkah Instalasi

-

Kunjungi https://llama.meta.com/ untuk mengunduh model

-

Isi formulir yang disediakan untuk mendapatkan instruksi pengunduhan

-

Gunakan framework seperti Hugging Face untuk mengimplementasikan model

-

Quantisasi model sesuai dengan spesifikasi hardware yang tersedia

Tips Optimasi Performa

-

Gunakan quantisasi Int4 untuk mengurangi kebutuhan memori

-

Batasi konteks window sesuai kebutuhan untuk meningkatkan kecepatan

-

Pertimbangkan untuk menggunakan beberapa GPU jika tersedia

Integrasi Llama 4 dengan Layanan Cloud

Llama 4 tersedia melalui berbagai platform cloud, menawarkan alternatif yang lebih mudah daripada menjalankannya secara lokal.

Azure AI Foundry dan Azure Databricks

Microsoft Azure menawarkan integrasi dengan Llama 4, memungkinkan pengguna memanfaatkan infrastruktur cloud untuk menjalankan model-model ini tanpa investasi hardware yang besar.

Hugging Face

Llama 4 adalah model besar pertama di Hugging Face yang menggunakan backend Xet—sistem penyimpanan berbasis chunk yang dirancang untuk model AI besar. Ini memungkinkan upload bobot model dalam skala terabyte dengan cepat dan meningkatkan kecepatan download.

NVIDIA NIM Microservices

NVIDIA menyediakan Llama 4 sebagai microservice NIM, memungkinkan akselerasi dengan software open-source NVIDIA dan performa optimal pada GPU NVIDIA.

Batasan dan Pertimbangan Lisensi

Meskipun Llama 4 adalah model open source, terdapat beberapa batasan penting dalam lisensinya:

-

Individu dan bisnis yang berbasis di Uni Eropa dilarang menggunakan atau mendistribusikan model-model ini, kemungkinan karena tuntutan regulasi dari peraturan AI dan privasi data di wilayah tersebut

-

Perusahaan dengan lebih dari 700 juta pengguna aktif bulanan harus mendapatkan lisensi khusus dari Meta

-

Meta dapat menyetujui atau menolak permintaan lisensi berdasarkan pertimbangannya

Batasan-batasan ini perlu dipertimbangkan sebelum mengintegrasikan Llama 4 ke dalam produk atau layanan komersial.

Masa Depan Llama 4 dan Pengembangan Berikutnya

Meta telah mengindikasikan bahwa Llama 4 hanyalah awal dari serangkaian model yang akan datang. Dalam jangka pendek, kita dapat mengharapkan:

-

Peluncuran Llama 4 Behemoth setelah pelatihan selesai

-

Kemungkinan model Llama 4 Reason yang difokuskan pada kemampuan penalaran

-

Pengumuman lebih lanjut di LlamaCon pada 29 April 2025

Dalam jangka panjang, Meta tampaknya berkomitmen untuk meningkatkan kemampuan Llama dalam melakukan tindakan umum, terlibat dalam percakapan alami dengan manusia, dan mengatasi masalah kompleks yang belum pernah dihadapi sebelumnya.

Llama 4 mewakili lompatan signifikan dalam teknologi AI open source, memperkenalkan inovasi arsitektur MoE, kemampuan multimodal native, dan konteks window yang revolusioner hingga 10 juta token. Dengan model Scout dan Maverick yang sudah tersedia, dan Behemoth yang akan datang, Meta memperkuat posisinya dalam persaingan AI global.

Kemampuan Llama 4 membuka berbagai kemungkinan baru untuk aplikasi AI di berbagai sektor, dari analisis dokumen kompleks hingga asisten AI yang lebih personal dan kontekstual. Meskipun persyaratan hardware yang tinggi dapat menjadi tantangan untuk beberapa pengguna, integrasi dengan layanan cloud menawarkan aksesibilitas yang lebih besar.

Seiring berlanjutnya perkembangan Llama 4 dan model-model berikutnya, kita dapat mengharapkan kemajuan lebih lanjut dalam kecerdasan buatan yang akan semakin mengintegrasikan teknologi ini ke dalam kehidupan sehari-hari dan mendorong inovasi di seluruh industri.

Pertanyaan Seputar Llama 4

Apa perbedaan utama antara Llama 4 dan model Llama sebelumnya?

Llama 4 mengenalkan arsitektur Mixture of Experts (MoE), kemampuan multimodal native dengan pendekatan early-fusion, dan konteks window yang jauh lebih besar hingga 10 juta token pada model Scout.

Berapa biaya untuk menggunakan Llama 4?

Llama 4 adalah model open source yang dapat diunduh dan digunakan secara gratis, dengan beberapa batasan lisensi. Biaya utama terkait dengan hardware yang diperlukan untuk menjalankannya atau biaya layanan cloud jika menggunakan melalui penyedia seperti Azure.

Apakah Llama 4 dapat dijalankan di laptop atau PC rumahan?

Menjalankan Llama 4 pada perangkat konsumen standar sangat menantang karena persyaratan hardware yang tinggi. Namun, dengan quantisasi yang tepat dan batasan pada konteks window, versi yang lebih ringan mungkin dapat dijalankan pada hardware high-end dengan GPU kuat dan RAM besar.

Apakah Llama 4 mendukung bahasa selain Inggris?

Ya, Llama 4 dilatih pada 200 bahasa, termasuk lebih dari 100 bahasa dengan lebih dari 1 miliar token masing-masing, dan secara keseluruhan 10x lebih banyak token multilingual dibandingkan Llama 3.

Bagaimana performa Llama 4 dibandingkan dengan model AI lainnya seperti GPT-4 atau Claude?

Meta mengklaim bahwa Llama 4 Maverick melampaui model-model sebanding seperti GPT-4o dan Gemini 2.0 dalam benchmark koding, penalaran, multilingualisme, konteks panjang, dan gambar. Sementara Llama 4 Behemoth (yang masih dalam pengembangan) dilaporkan mampu mengalahkan GPT-4.5, Claude Sonnet 3.7, dan Gemini 2.0 Pro pada benchmark yang berfokus pada STEM.

Apakah Anda sudah mencoba Llama 4? Kami sangat ingin mendengar pengalaman Anda dengan model AI terbaru ini! Bagikan proyek, aplikasi, atau percobaan Anda dengan Llama 4 di kolom komentar. Jika Anda menemukan artikel ini bermanfaat, jangan ragu untuk membagikannya di media sosial Anda untuk membantu orang lain memahami kemampuan revolusioner dari teknologi AI terbaru ini.

Menurut Anda, bagaimana Llama 4 akan mengubah cara kita berinteraksi dengan AI di masa depan? Apakah konteks window 10 juta token akan membuka kemungkinan aplikasi baru yang belum pernah kita bayangkan sebelumnya? Berikan pendapat Anda dan mari berdiskusi tentang masa depan AI bersama!

BahasBerita BahasBerita Informasi Terbaru Seputar Internet

BahasBerita BahasBerita Informasi Terbaru Seputar Internet